你有没有试过:熬夜写完3000字剧本,想用AI生成视频,结果男主角每帧换一张脸,前一秒在咖啡厅、下一秒跳到火星,连戏?不存在的。反复抽卡100次,只能含泪发朋友圈:”AI虽好,可惜不听话。”

我也被这个问题折磨了很久。所以花了几个月时间,做了一个完全开源的项目,分享给大家——

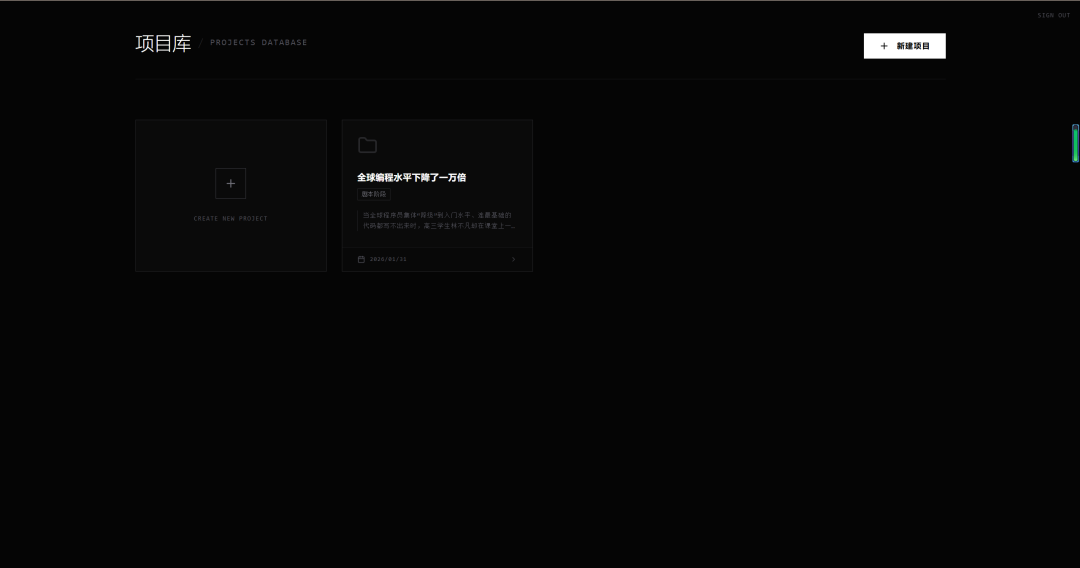

BigBanana AI Director(AI 短剧/漫剧工场)

GitHub:https://github.com/shuyu-labs/BigBanana-AI-Director

一句话概括:把你的故事文本变成可控的视频成片,全程不掉链子。

它不是让AI随机”抽卡”出画面,而是模拟真实影视制作流程——先定妆、再搭景、然后画分镜、最后合成片。每个环节你都能干预,每帧画面都受约束,告别”薛定谔的男主角”。

完全开源,免费使用,代码随便看。 希望能帮到同样在折腾AI视频的朋友们。

它能做什么?

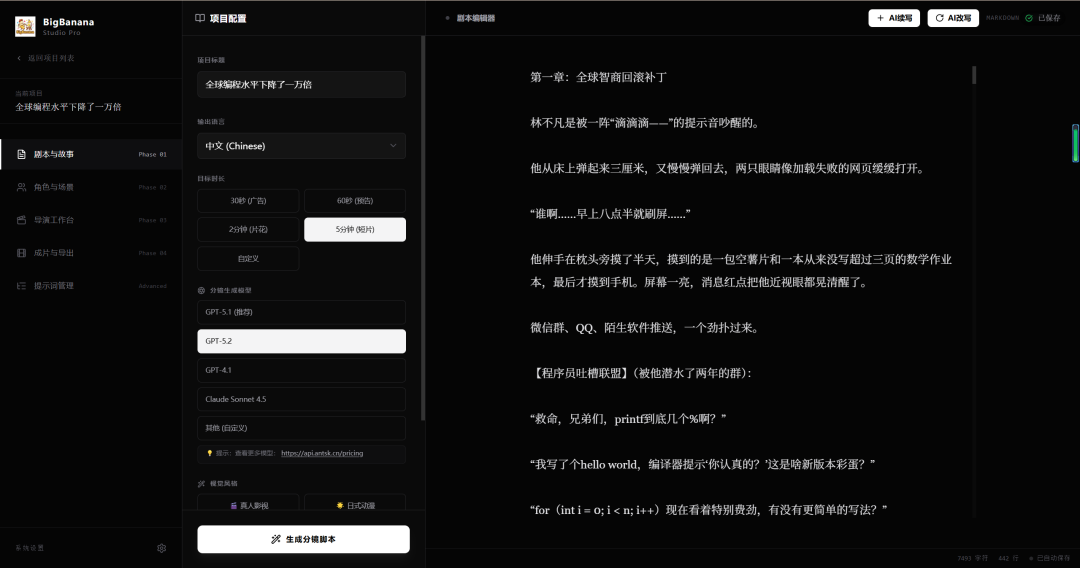

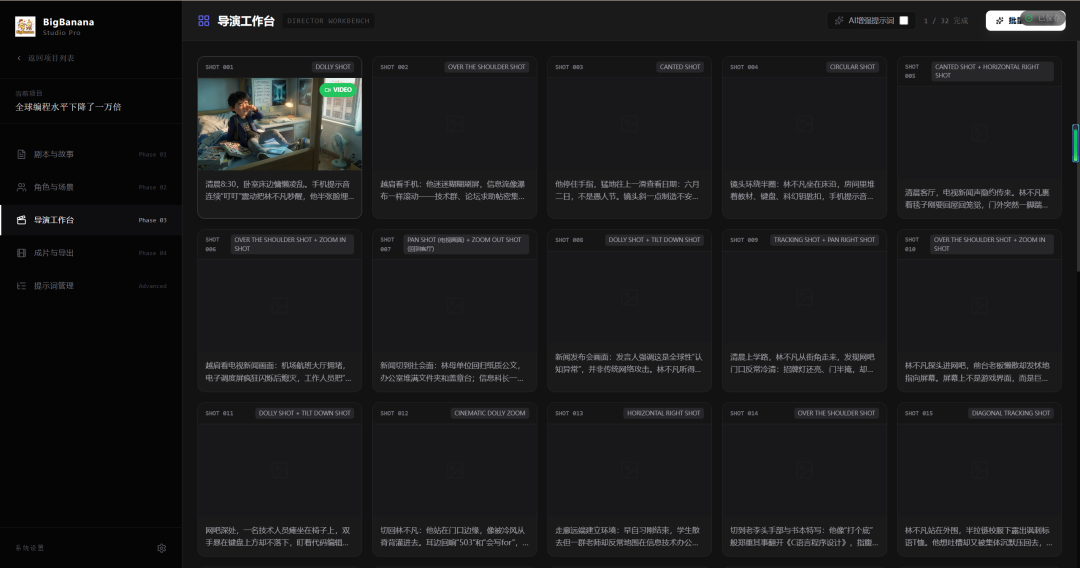

🎬 功能一:智能剧本拆解

场景:你有一篇5000字的小说片段,想做成3分钟短剧。

效果:粘贴进去,AI自动拆成”场景→镜头→台词”的标准分镜表,还能设定目标时长,它帮你规划节奏密度。不用手动分段,省下2小时。

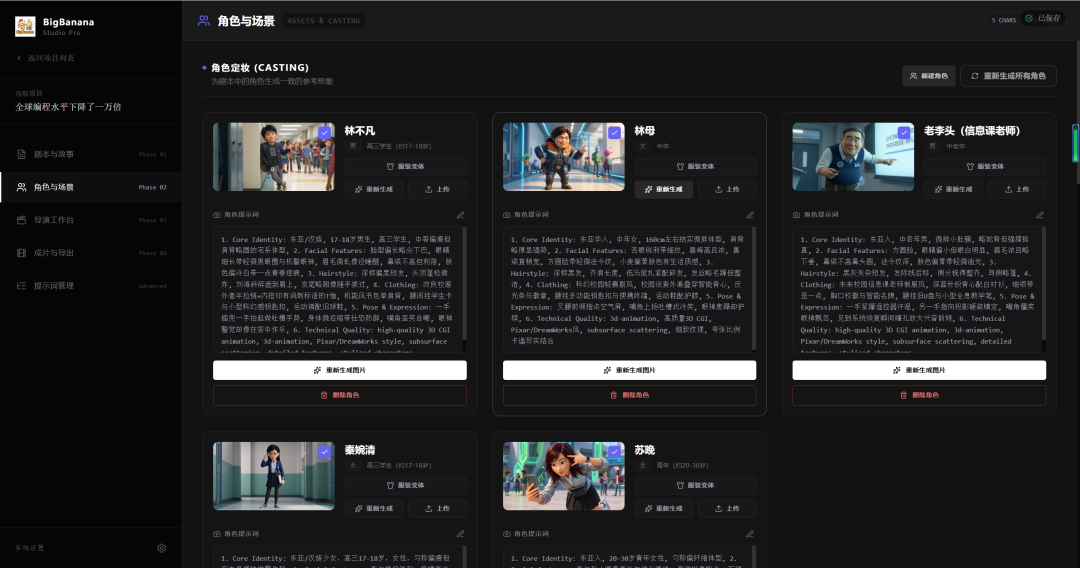

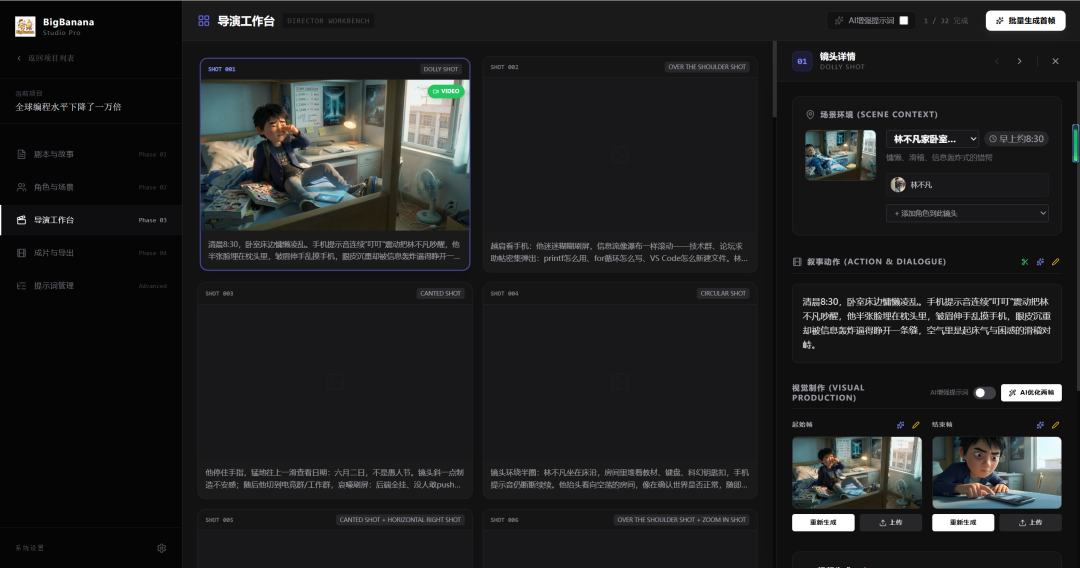

🎭 功能二:角色定妆 + 衣橱系统

场景:男主要有”日常装”和”战斗装”两套造型,但脸不能变。

效果:先生成一张”定妆照”作为基准,再基于它生成不同服装变体。所有后续画面都参考这张脸,彻底锁死五官,换衣服不换人。

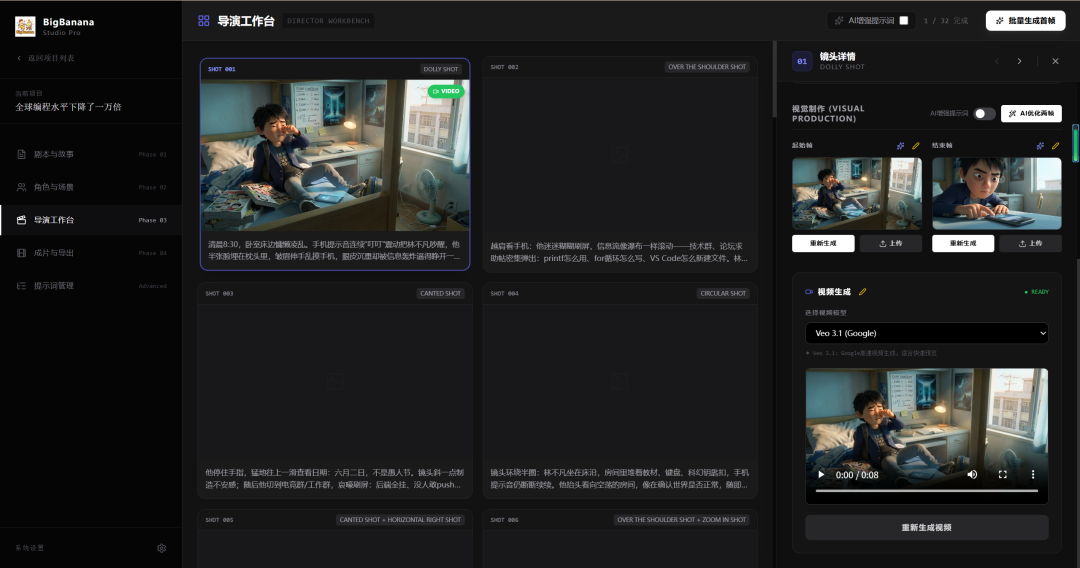

🖼️ 功能三:关键帧驱动的视频生成

场景:你要一个”男主回头”的镜头,普通AI随便动动就糊弄你。

效果:先画起始帧(正面)和结束帧(回头状态),再让Veo模型在两帧之间”补间”出丝滑动画。起点终点你说了算,过程AI帮你填。

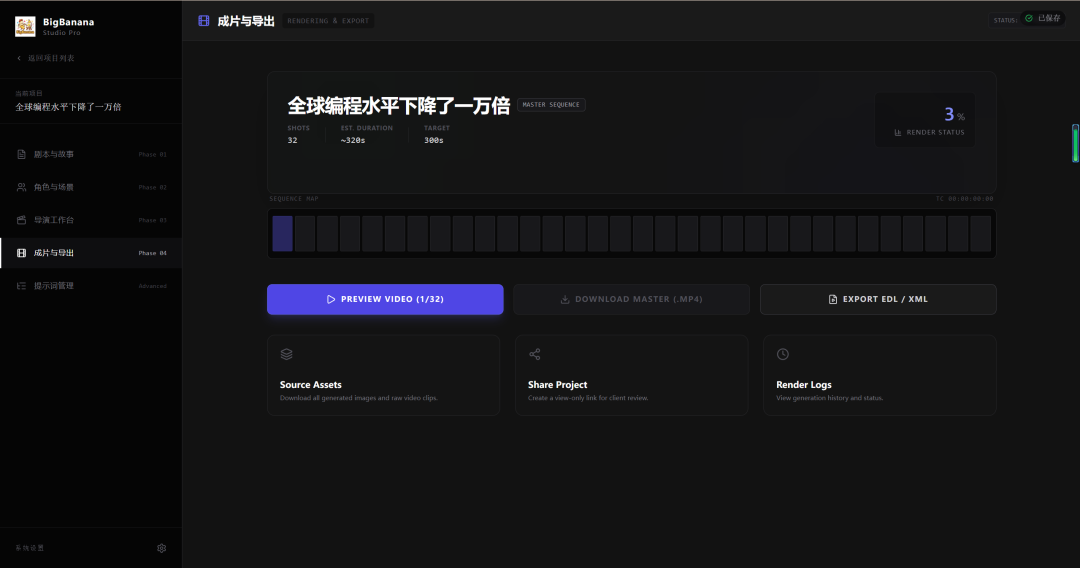

📦 功能四:一键导出 + 渲染追踪

场景:生成了20个镜头,想批量导出去Premiere剪辑。

效果:时间轴预览全部片段,一键导出高清关键帧和MP4视频,还能实时看渲染进度。专业后期无缝衔接。

✏️ 功能五:全流程手动微调

场景:AI生成的分镜提示词有点跑偏,想手动改几个词。

效果:每个分镜的角色列表、动作描述、画面提示词都能直接编辑。AI打底,人类精修,控制权始终在你手里。

技术架构一览

整体架构可以简化为三层:

┌─────────────────────────────────────────────────┐

│ 输入层:剧本/故事文本 │

│ ↓ GPT-5.1 智能拆解 │

├─────────────────────────────────────────────────┤

│ 资产层:角色定妆照 + 场景概念图 │

│ ↓ Gemini 3 Pro 约束生成 │

├─────────────────────────────────────────────────┤

│ 输出层:关键帧 → Veo/Sora 视频插值 → MP4成片 │

└─────────────────────────────────────────────────┘

设计巧思:

-

“约束优先”而非”随机生成”:每帧画面都必须参考角色图和场景图,杜绝AI自由发挥 -

纯前端架构:React 19 + IndexedDB 本地存储,数据不离开你的浏览器,隐私无忧 -

统一API调度:通过AntSK接口一站式调用文本/图像/视频模型,不用切换多个平台

3步快速上手

|

|

|

|

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

代码仓库:https://github.com/shuyu-labs/BigBanana-AI-Director

在线体验:https://bigbanana.tree456.com/

API获取:https://api.antsk.cn/ (新用户有免费额度)

为什么开源?

做这个项目的初衷很简单:让没有影视制作经验的人,也能把脑子里的故事变成视频。

AI视频这个领域变化太快,一个人闭门造车肯定跟不上。开源出来,大家一起迭代,才能做得更好。

接下来计划做的功能:

-

🔊 AI配音与口型同步 -

🎵 BGM智能匹配 -

📱 移动端适配

欢迎提Issue、提PR,或者单纯来聊聊你的想法。